Peluang Big Data Indonesia, Big Data Trend 2017

Peluang Big Data Indonesia – Big Data Administrator. Tahun 2016 merupakan tahun yang penting untuk big data, termasuk juga dengan big data Indonesia.

Peluang Big Data Indonesia – Big Data Administrator. Tahun 2016 merupakan tahun yang penting untuk big data, termasuk juga dengan big data Indonesia. Dengan organisasi penyimpanan, pengolahan, dan penggalian nilai dari segala bentuk dan ukuran data yang lebih besar. Pada tahun 2017, sistem yang mendukung volume data yang besar baik data terstruktur dan data yang tidak terstruktur akan terus meningkat. permintaan pasar akan platform yang membantu penjaga Data mengatur dan mengamankan big data sementara memberdayakan pengguna akhir untuk menganalisis data tersebut. Sistem ini akan mature untuk beroperasi dengan baik dalam sistem TI perusahaan dalam system standar maupun system enterprise.

Sebagaimana dikutip dan disadur dari tableau, bahwa setidaknya ada 10 peluang perkembangan big data di dunia. Demkian juga paling tidak yang terjadi dengan perkembangan big data Indonesia. Ke sepuluh peluang tersebut antara lain :

1. Big Data Menjadi Lebih Cepat dan Mudah Dilakukan Pendekatan

Pilihan memperluas system untuk mempercepat Hadoop.

Tentu, Anda dapat melakukan penggunaan machine learning dan melakukan analisis sentimen pada Hadoop, tapi pertanyaan pertama orang yang sering bertanya adalah: Seberapa cepat kah SQL interaktif? SQL, setelah semua yang dilakukan, adalah saluran untuk pengguna bisnis yang ingin menggunakan data Hadoop supaya lebih cepat, dashboard KPI lebih berulang serta analisis eksplorasi.

Hal ini diperlukan untuk kecepatan yang telah memicu adopsi database lebih cepat seperti Exasol dan MemSQL, penyimpanan yang berbasiskan Hadoop seperti Kudu, dan teknologi yang memungkinkan query lebih cepat. Menggunakan mesin SQL di atas Hadoop (Apache Impala, Hive LLAP, Presto, Phoenix, dan bor) dan teknologi OLAP di atas Hadoop (AtScale, Jethro Data, dan Kyvos Insights), akselerator permintaan ini lebih lanjut mengaburkan garis antara datawarehouse tradisional dan dunia big data.

2. Big Data tidak lagi Hanya Hadoop

Tool yang dibangun untuk Hadoop menjadi Usang

Dalam tahun-tahun sebelumnya, kami melihat beberapa teknologi meningkat dengan gelombang big data yang memenuhi kebutuhan analisis pada Hadoop. Tapi perusahaan yang memiliki kompleksitas data, lingkungan yang heterogen tidak lagi ingin mengadopsi jalur akses BI siled hanya untuk satu sumber data (Hadoop). Jawaban atas pertanyaan mereka dikubur dalam berbagai sumber mulai dari sistem catatan warehouse cloud, data terstruktur dan tidak terstruktur dari keduanya yaitu Hadoop dan sumber-sumber non-Hadoop. (Kebetulan, bahkan database relasional menjadi siap dengan big data. SQL Server 2016, misalnya, baru-baru ini menambahkan dukungan JSON).

Pada tahun 2017, pelanggan akan menuntut analisis pada semua data. Platform yang berbasis data- dan sumber-agnostik akan berkembang sementara mereka yang tujuan pembangunan untuk Hadoop dan gagal untuk menyebarkan seluruh kasus penggunaan akan terpuruk di pinggir jalan perkembangan big data. Keluarnya Platfora berfungsi sebagai indikator awal dari kecenderungan ini

Baca Juga : 60 Top Open Source Untuk Big Data

3. Organisasi pengembangan danau data dari mendapatkan-menjadikannya untuk mendorong value

Sebuah danau data seperti waduk buatan manusia.

Pertama bendungan Anda berakhir (membangun cluster), maka Anda membiarkannya terisi dengan air (data). Setelah Anda menetapkan danau, Anda mulai menggunakan air (data) untuk berbagai keperluan seperti pembangkit listrik, minum, dan menciptakan segala keperluan (analisis prediktif, ML, keamanan cyber, dll).

Sampai sekarang, hydrating danau telah menjadi tujuan itu sendiri. Pada tahun 2017, yang akan berubah yaitu sebagai pembenaran bisnis untuk Hadoop semakin kencang. Organisasi akan menuntut penggunaan berulang dan lincah dari danau data untuk mendapatkan jawaban yang cepat. Mereka akan hati-hati mempertimbangkan hasil bisnis sebelum berinvestasi pada personil(SDM), data, dan infrastruktur. Ini akan mendorong kemitraan yang lebih kuat antara bisnis dan TI. Dan platform self-service akan mendapatkan pengakuan lebih sebagai tool untuk memanfaatkan aset big data ini.

4. Arsitektur Yang Semakin Matang untuk menolak satu ukuran yang cocok untuk semua Framework

Hadoop tidak lagi hanya sebuah platform batch-processing untuk kasus penggunaan data ilmiah.

Hal ini telah menjadi mesin multi-tujuan untuk analisis ad hoc. Penggunaan tool Ini bahkan digunakan untuk pelaporan operasional pada hari-hari dengan beban kerja-jenis tradisional yang ditangani oleh data warehouse

Pada tahun 2017, organisasi akan merespon kebutuhan-kebutuhan hybrid dengan mengejar menggunakan kasus-spesifik pada desain arsitektur. Mereka akan meneliti sejumlah faktor termasuk pengguna personal, pertanyaan, volume, frekuensi akses, kecepatan data, dan tingkat agregasi sebelum melakukan strategi data. arsitektur-referensi yang modern ini akan menjadi suatu kebutuhan. Mereka akan menggabungkan alat self-service yang terbaik pada data-prep, Hadoop Core, dan platform analisis pengguna akhir dengan cara yang dapat berulang sebagai tahapan evolusi pada kebutuhan tersebut. Fleksibilitas arsitektur ini pada akhirnya akan mendorong pilihan teknologi.

5. Ragam Data, bukan volume atau kecepatan, mendorong investasi pada Big Data

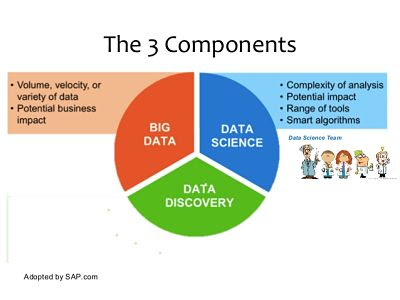

Gartner mendefinisikan big data sebagai tiga Vs:

volume yang tinggi (Volume), kecepatan yang tinggi (velocity), dan berbagai aset informasi tinggi (variety). Sementara ketiga Vs tersebut berkembang, variety menjadi pendorong terbesar tunggal terhadap investasi pada big data, seperti yang terlihat dalam hasil survei terbaru oleh New Vantage Partners. Tren ini akan terus tumbuh terhadap perusahaan yang berusaha untuk mengintegrasikan lebih banyak sumber dan fokus pada "ekor panjang" dari big data. Dari schema-free JSON untuk jenis type bersarang di dalam database lain (relasional dan NoSQL), data non-flat (Avro, Parquet, XML), format data yang tumbuh berlipat dan konektor data menjadi penting. Pada tahun 2017, platform analisis akan dievaluasi berdasarkan kemampuan mereka untuk menyediakan konektivitas langsung untuk sumber-sumber data yang berbeda atau memiliki variasi data yang banyak.

6. Spark dan Pembelajaran Mesin Yang Menjalankan Big Data

Apache Spark, dibuat untuk komponen ekosistem Hadoop, sekarang menjadi platform big data pilihan bagi perusahaan.

Dalam sebuah survei dari data architect, manajer TI, dan analis BI, hampir 70% dari responden telah menyukai Spark lebih dari MapReduce yang merupakan tool incumbent, yang merupakan batch-oriented dan tidak mampu menyesuaikan dirinya untuk aplikasi interaktif atau real-time stream processing.

Kemampuan besar menghitung pada big data yang ada pada high platform menampilkan perhitungan intensif dari machine learning, AI, dan algoritma grafik. Microsoft Azure ML khususnya telah diambil sebagai platform awal yang bersahabat dan integrasi yang mudah dengan platform Microsoft yang ada. Membuka ML kepada massa akan mengarah pada penciptaan model yang lebih dan memiiki ukuran petabyte dalam menghasilkan aplikasi data. Sebagai machine learning dan sistem pintar, semua mata akan tertuju pada penyedia software swalayan untuk melihat bagaimana mereka membuat data ini didekati dan digunakan oleh pengguna akhir.

7. Konvergensi IOT, Awan / Cloud, dan Big Data Menciptakan Peluang Baru Untuk Analisis Swalayan

Tampaknya bahwa segala sesuatu di 2017 akan memiliki sensor yang mengirimkan informasi kembali ke induk atau aplikasi asal tersebut.

IOT menghasilkan volume big data terstruktur dan tidak terstruktur, dan meningkatnya pangsa big data ini untuk digunakan pada layanan cloud. Data yang ada bisa head terogen dan tersimpan di beberapa sistem relasional dan non-relasional, dari cluster Hadoop ke database NoSQL. Sementara inovasi dalam penyimpanan dan managed services telah mempercepat proses capture, mengakses dan memahami data itu sendiri masih merupakan tantangan terakhir yang signifikan. Akibatnya, tumbuhnya permintaan untuk tool analisis yang smooth dalam menghubungkan dan menggabungkan berbagai sumber data yang ada di cloud. Tool tersebut memungkinkan perusahaan untuk mengeksplorasi dan memvisualisasikan jenis data yang disimpan di mana saja, membantu mereka menemukan peluang yang tersembunyi dalam investasi IOT mereka.

8. Mempersiapkan Data Self-Service menjadi Mainstream Sebagai Pengguna Akhir Yang Mulai untuk membentuk Big Data

Membuat data Hadoop dapat diakses oleh pengguna bisnis adalah salah satu tantangan terbesar di zaman kita.

Munculnya self-service analytics platform telah meningkatkan perjalanan perkembangan big data Indonesia ini. Tapi pengguna bisnis ingin mengurangi waktu dan kompleksitas ketika mempersiapkan data untuk analisis, yang paling penting adalah ketika berhadapan dengan berbagai jenis data dan format data ataupun metadata.

Tool self-service untuk perparasi data Agile tidak hanya memungkinkan data Hadoop akan disiapkan pada sumbernya tetapi juga membuat data yang tersedia sebagai snapshot untuk eksplorasi lebih cepat dan lebih mudah. Kita telah melihat sejumlah inovasi dalam hal ini dari perusahaan yang berfokus pada persiapan Data pengguna akhir untuk big data seperti Alteryx, Trifacta, dan Paxata. Tool seperti ini menurunkan hambatan masuk untuk pengadopsi Hadoop lebih telat dan lamban dan akan terus untuk mendapatkan traksi di tahun 2017.

Baca Juga : Bisakah Big Data Merubah Dunia Anda ?

9. Big Data Bertumbuh: Hadoop Menambah Standar Perusahaan

Kita dapat melihat tren yang berkembang dari Hadoop menjadi bagian inti dari lanskap perusahaan IT.

Dan pada tahun 2017, kita akan melihat lebih banyak investasi dalam komponen keamanan dan pemerintahan di sekitar sistem perusahaan. Apache Sentry menyediakan sistem untuk fine-grained, otorisasi berbasis peran data dan metadata disimpan di cluster Hadoop. Apache Atlas, dibuat sebagai bagian dari inisiatif organisasi data, memberdayakan organisasi untuk menerapkan klasifikasi data yang konsisten di seluruh ekosistem data. Apache Ranger memberikan administrasi keamanan terpusat untuk Hadoop.

Pelanggan mulai mengharapkan jenis kemampuan dari platform RDBMS kelas perusahaan mereka. Kemampuan ini bergerak ke garis depan munculnya teknologi big data, sehingga belum mampu menghilangkan penghalang lain untuk adopsi perusahaan.

10. Rise of katalog metadata Membantu Orang Menemukan Big Data Analisis dengan Baik

Untuk waktu yang lama, perusahaan membuang data karena mereka memiliki terlalu banyak data untuk diproses.

Dengan Hadoop, mereka dapat memproses banyak data, namun data tersebut umumnya tidak terorganisir dalam cara yang dapat ditemukan

katalog metadata dapat membantu pengguna menemukan dan memahami data layal yang relevan dalam menganalisis menggunakan alat self-service. Gap yang membutuhkan pelanggan ini sedang diisi oleh perusahaan seperti Alation dan Waterline yang menggunakan machine learning untuk mengotomatisasi pekerjaan dalam menemukan data dalam Hadoop. Katalog file tersebut menggunakan tag, mengungkap hubungan antara aset data, dan bahkan memberikan saran permintaan melalui UIS yang dicari. Hal ini membantu baik konsumen dan pelayan data untuk mengurangi waktu yang dibutuhkan untuk percaya, menemukan, dan akurasi query data. Pada tahun 2017, kita akan melihat lebih banyak kesadaran dan permintaan untuk penemuan self-service, yang akan tumbuh sebagai perpanjangan alami dari analisis swalayan pada perkembangan big data Indonesia.

Apakah anda dan saya telah siap untuk menyambut era big data Indonesia? Hanya diri kita masing2 yang bisa menjawab tantangan tersebut. Untuk diskusi dan belajar bersama mengenai big data, kita bisa membaca big data tutorial yang akan tayang di blog big data administrator.

Reff :

big data Indonesia, big data tutorial, contoh aplikasi big data, konferensi big data indonesia 2016, idbigdata, belajar big data, makalah big data, apa itu big data, solusi 247, data science Indonesia